세계적인 기업으로 떠오른 NVIDIA의 CEO 젠슨황은 인공지능 시대에 GPU(Graphics Processing unit)가 핵심 인프라 기술이 될 줄 알고 만들었을까? 딥러닝의 아버지로 불리는 제프리 힌튼은 2024에 노벨물리학상을 수상하는 영예를 안았다. 그는 자신의 눈부신 연구적 성취를 예견했을까? 사실 NVIDIA는 초창기에 게임 그래픽 연산 처리를 위해 GPU를 개발하고 판매했다. 힌튼은 아무도 주목하지 않았던 1980년대부터 지속적으로 딥러닝에 관련된 주요 이론적 알고리즘을 연구하고 제안했다. 그 때 연구된 아이디어들은 이후에, GPU라는 연산장치와 만나며 현실 세계에서 빛을 보게 됐다.

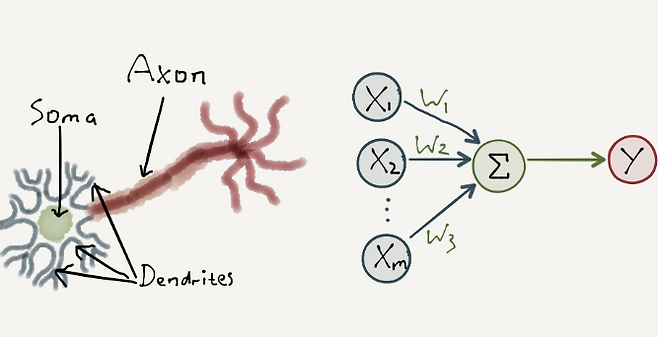

젠슨황과 힌튼이 전 세계의 주목을 받게 된 이유는 인공지능 기술의 비약적인 발전 때문인데, 엄밀히 말하자면 인공지능 기술 중에서도 딥러닝 때문이다. 딥러닝은 인간의 신경 시스템을 모방한 인공 신경망에 기반한 인공지능 학습 방식이다. 이 기술의 바탕이 된, 생물학적 신경 세포(뉴런, neuron) 구조는 세가지 요소로 이루어져 있다. : 다른 뉴런으로부터 신호를 입력받는 수상 돌기(dendrites), 받은 신호를 처리해서 신호의 전달 여부를 판단하는 세포체(soma), 처리된 신호를 다음 뉴런으로 전달하는 통로인 축삭돌기(axon)이다. 축삭 돌기와 다음 뉴런의 수상 돌기 사이에 위치하여, 신경을 이어주는 부분을 시냅스라고 한다.

이러한 인간의 신경 세포가 신호를 전달하는 원리를 인공적으로 만든 것이 인공 신경 세포인 퍼셉트론(perceptron)이다. 퍼셉트론은 입력이 들어오면, 입력값에 가중치를 곱해서 더한 뒤, 활성화 함수를 통과 시켜 출력값을 생성하여 전달한다. 이처럼, 딥러닝의 기본 단위인 퍼셉트론은 인간의 신경 세포의 구조와 동작 방식을 모방해서 만들어졌다.

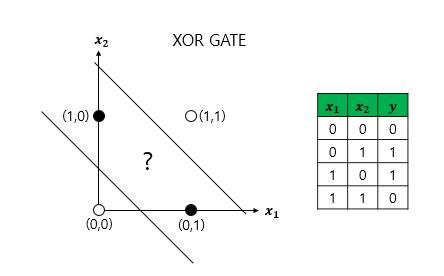

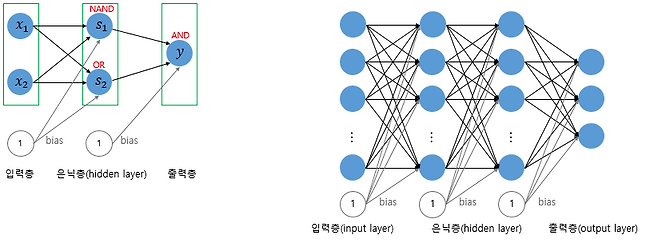

신경 세포가 해당 신호를 전달할지 말지를 결정하는 것처럼, 퍼셉트론은 입력된 데이터를 둘중 하나로 분류하는 이진 분류기 역할을 한다. 하지만, 인공 신경망 연구는 암흑기를 맞이하게 되는데, 퍼셉트론 연구의 한계를 증명한 연구가 발표되었기 때문이다. 퍼셉트론은 XOR (두가지 입력이 들어왔을 때, 두 입력이 다르면 1, 같으면 0을 출력하는 논리 연산) 문제를 해결할 수 없다는 것이다. 이러한 문제점을 해결하기 위해 고안된 것이 다층 퍼셉트론(Multi Layer Perceptron, MLP)이다. 선 하나로 구분할 수 없는 입력들을 구분하기 위해 여러개 선을 조합해서 구분하는 것이다. MLP는 인풋 레이어(입력층)와 히든 레이어(은닉층), 아웃풋 레이어 (출력층)으로 이루어지는데, 히든 레이어가 많은 신경망을 심층 신경망 (Deep Neural Network, DNN)이라고 부르고, 이러한 심층 신경망을 학습시키는 것이 딥러닝이다.

딥러닝의 목표는 입력을 받아, 계산한 출력값과 실제값 사이의 손실(loss)을 줄이는 가중치(weights,인공지능 모델 파라미터라고 불린다.)를 찾는 것이다. 손실을 수치화한 손실 함수(loss function, 최적화 문제에서는 폭넓은 의미로 최적화의 대상이 되는 함수를 objective function이라고 부른다. 딥러닝에서는 손실을 줄이기 위한 것이 목적이므로, loss function을 목적 함수(objective function)라고 말할 수 있다)를 정의하고, 가중치를 어떻게 조정해야 손실이 작아지는지를 찾아가는 과정이다. 하지만, 출력은 정답과 비교해 틀렸는지를 알 수 있어도 우리가 구하고자 하는 가중치들은 대부분 은닉층에 존재하는데, 어떻게 계산하고, 업데이트할 수 있을까?

딥러닝의 아버지인 제프리 힌튼은 동료들과 이 가중치를 계산하기 위해, 역전파(backpropagation)라는 방법을 제안했다. (참고: Learning representations by back-propagating errors, 저자: David E. Rumelhart, Geoffrey E. Hinton, Ronald J. Williams, 역전파라는 개념은 1974년에 미국의 사회 과학자이자 기계 학습의 개척자인 Paul Werbos이 제안했다. (개인적으로 그가 기계 학습(머신 러닝이라고 불리는 인공지능 방법) 연구자이면서 사회과학자인 것이 놀랍다. 힌튼은 이 알고리즘을 딥러닝에 실질적으로 적용하고 검증했다.)

역전파는 출력층에서 입력층의 방향으로, 미분의 연쇄법칙을 적용해서, 각 가중치에 대한 손실 함수의 편미분을 계산하는 방법이다. 미분을 계산한다는 것은 결국 변화량을 구하는 것으로, 가중치의 변화에 따라, 손실이 얼마나 변하는지를 의미한다. 이러한 계산을 통해서, 각 가중치가 손실에 얼마나 영향을 주는지 파악하고 손실이 줄어드는 방향으로 가중치를 업데이트 할 수 있다. 사람이 학습을 할 때, 각자 학습 목표를 세우는 것처럼, 딥러닝의 목표는 입력과 출력 사이의 관계인 가중치를 찾아내는 것이다. 이 가중치는 학습 과정에서 자동적으로 계산되는 것으로, 인간이 직관적으로 파악하기 어려운 데이터의 관계도 알아낼 수 있다는 효용성이 있는 기술이다. 이를 아주 간단한 일차함수 y = ax + b에 비유하면, 방대한 데이터에서 관찰할 수 있는 x와 y값을 통해, a와 b 값을 스스로 추론해 나가는 것이 딥러닝이다.

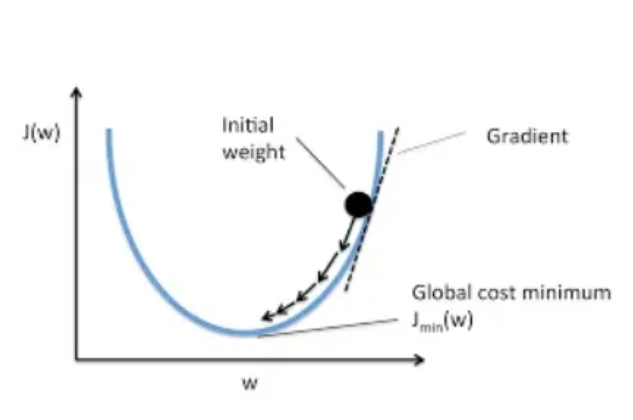

손실을 최소화하는 가중치를 찾기 위해, 앞서 언급한 역전파를 이용해서, 손실함수의 기울기(그래디언트, gradient)를 계산했다. 기울어진 방향으로 내려가면서(기울기가 가리키는 방향으로 내려가기 위해서, 실제 수식에서는 기울기 값 앞에 마이너스가 붙음), 손실이 줄어드는 방향으로 가중치가 업데이트 된다. 점차적으로 손실이 줄어드는 방향으로 업데이트 되기 때문에, 이 알고리즘에는 경사하강법(gradient descent)이라는 이름이 붙었다. 순간 이동을 통해 원하는 지점에 도달할 수 없는 것처럼, 최소 손실은 한번에 찾아지지 않는다. 경사하강법 알고리즘은 안개가 자욱한 산을 조금씩 조심스럽게 내려가는 것에 종종 비유된다.

딥러닝이라는 기술이 인간의 신경 시스템을 모방한 부분이 개인적으로 흥미로웠다. 또한, 딥러닝이 학습을 통해 목적을 달성해가는 과정도 인생과 닮아있는 부분이 있는 것 같다. 딥러닝이 최소 손실 지점을 찾기 위해 단계를 밟아가는 것처럼, 제프리 힌튼과 젠슨황의 성공이 한번에 이루어진 것이 아닌 것처럼, 내 인생에도 그런 걸음 걸음들이 필요하지 않을까 생각해본다. 최소 손실을 찾아나갈 때, 기울기가 완만해질 때도 가파를 때도 있는 것처럼, 절망의 골짜기에 빠진 것처럼 제자리 걸음만 하고 있다고 느껴지는 순간이 있었다. 하지만, 그 조금씩 성장하고 있다는 것이 느껴지는 시간도 있었다. 아직은 경험해 보지 못했지만, 언젠가는 쥐구멍에 볕 들 듯이 예상치 못한 빛이 스며들어 퀀텀 점프를 한 것 같은 날도 있을 것이다.

뿐만 아니라, 결국 딥러닝은 예측값과 실제값 사이의 손실(실제로 다양한 형태의 손실 함수가 있다)을 최소화하는 가중치를 구하는 것이 목적이다. 이처럼 인생에도 각자만의 목적이 필요하지 않을까 하는 생각이 든다. 사람마다 삶의 기준과 목적이 다르다. 나만의 가치를 찾아가면서, 내가 현재 위치한 자리에서, 조금씩 내가 정의한 'Do the next right thing'을 해나가며, 현재 위치에서 최선의 삶을 살아가는 것, 조금씩 내가 원하는 삶에 가까워지는 것, 타인이 정의한 성공이 아닌, 나만의 삶을 이루어가는 것이 나는 성공이라고 생각한다.

코너명: 내가 만나온 언어 모델들

통계적 언어 모델부터 대규모 언어 모델까지 그동안 만나왔던 "사람의 언어를 이해하고 생성하는" 인공지능 기술들을 정리해 봅니다.

글쓴이:선영

인공지능 자연어처리 분야에서 석사 학위를 취득하고 AI 연구 개발자로 일하고 있습니다. <그 일을 하고 있습니다>를 공저했습니다. 삶에 도움이 되는 인공지능을 개발하기 위해 연구하고 있습니다.

#지식토스트

Copyright © 해당 글의 저작권은 '세상의 모든 문화' 필자에게 있습니다.