성 착취물 만드는 AI 앱…“애플·구글은 뒷짐” [플랫]

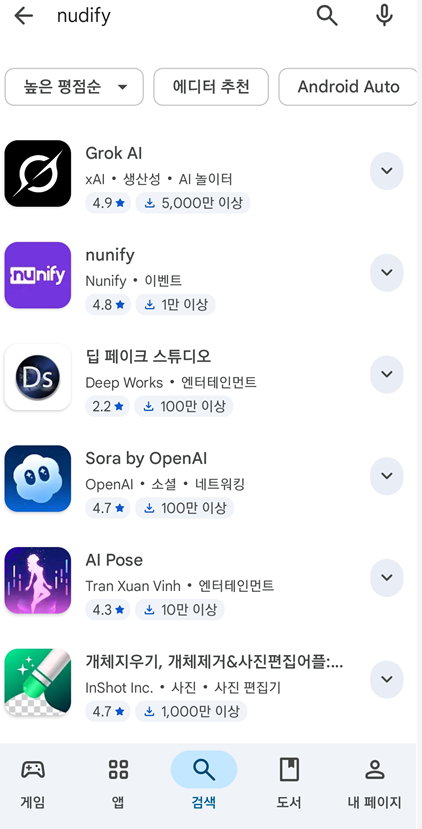

구글의 애플리케이션(앱) 마켓인 플레이스토어에 ‘누디파이’(Nudify·누드 합성)라는 키워드를 넣자 관련 앱이 주르륵 뜬다. 여성의 신체를 노골적으로 묘사한 이미지를 내걸고 있는 이들 앱의 다운로드 수는 적게는 수만회, 많게는 수천만회에 이른다.

인공지능(AI)으로 성 착취 이미지를 생성하는 누디파이 앱이 활개를 치고 있다. 앱 마켓을 운영하는 구글과 애플이 이를 방치하며 짭짤한 수익을 올리고 있다는 지적도 나온다.

미국의 비영리단체 기술투명성프로젝트(TTP)는 27일(현지시간) 이 같은 내용의 보고서를 공개했다. TTP는 최근 AI 챗봇 ‘그록’이 성 착취 이미지 생성·유포로 논란이 인 것을 계기로 양대 앱 마켓(플레이스토어·앱스토어)을 조사했다.

보고서에 따르면, TTP가 문제라고 지적한 누디파이 앱은 전 세계적으로 다운로드 건수가 약 7억500만회를 기록했다. 이들 앱이 올린 누적 매출만 1억1700만달러(약 1665억원)으로 추정된다. 애플과 구글이 인앱 결제 수수료(최대 30%)를 가져간다는 것을 고려하면 이들이 누디파이 앱을 통해 얻은 수익은 수백억원에 달할 것으로 보인다.

TTP는 AI로 생성한 가상의 여성 이미지를 이용해 누디파이 앱 테스트도 진행했다. 옷을 입은 여성 사진을 주고 옷을 벗겨달라고 하거나, 여성의 얼굴 사진만 주고 나체와 합성해달라고 주문했다. 그러자 안드로이드 앱 55개와 iOS 앱 47개가 나체의 여성 이미지를 만들어냈다. TTP는 “양대 마켓이 사용자 안전을 강조하면서도 누디파이 앱의 확산 속도를 따라가지 못하고 있다”고 꼬집었다.

TTP는 “프롬프트(명령어) 몇 줄 또는 버튼 한 번으로 여성의 옷을 벗기거나 성적인 영상으로 만드는 것이 가능했다”면서 “경고나 차단 장치는 거의 없었으며 상당수 앱이 전 연령 혹은 12세 이상으로 분류돼 있었다”고 지적했다.

생성형 AI가 대중화한 이후 이를 활용한 성 착취물 제작 문제는 끊이지 않고 있다. 최근에는 일론 머스크의 xAI가 SNS 엑스 내에서 운영하는 챗봇 그록에 이미지 편집 기능이 추가되면서 비판에 직면했다. 이용자들이 이 기능을 활용, 원본 당사자 동의를 받지 않은 성 착취물을 다량 생성·유포했기 때문이다. 미성년인 피해자가 속출하면서 미국·유럽연합(EU) 등 각국 당국은 공식 조사에 착수했다. 국내에선 지난 14일 방송미디어통신위원회가 그록에 청소년 보호 장치를 마련하라고 요청했다.

국내에서도 AI를 이용한 성 착취물 제작 및 유포는 심각한 문제지만 법이 현실을 따라가지 못하는 실정이다. 2024년 개정된 성폭력처벌법은 딥페이크 성 착취물 제작·유포는 물론 시청·소지·구입·저장한 경우에도 3년 이하의 징역 또는 3000만원 이하 벌금으로 처벌하도록 돼 있다. 그러나 지난해 AI로 만든 성 착취물의 피해자가 특정되지 않으면 성폭력처벌법상 허위영상물 유포죄로 처벌할 수 없다는 법원 판결이 나오며 한계를 노출했다.

▼ 최민지 기자 ming@khan.kr

플랫팀 기자 flat@kyunghyang.com

Copyright © 경향신문. 무단전재 및 재배포 금지.

- 금 -11%·은 -31%, 개미는 월요일 오전 9시가 두렵다···‘AI 과열론’에 워시 지명 겹쳐

- “무슨 돈으로 주식” “투자로 더 벌어”…5000피 시대의 ‘두 얼굴’

- 이란 공격 말렸던 사우디·이스라엘도 “이란 공격 지지”···트럼프, 이란과 “대화 중”

- “흑흑 엄마 술 취한 사람이 때렸어”…알고 보니 인공지능 보이스피싱

- 이광재 “우상호 승리 돕겠다…노무현처럼 어려운 길로” 강원지사 불출마 선언

- 아틀라스가 공장 들어오는 날, 한국사회는 준비돼 있나

- 이 대통령 “무슨 수 써서라도 집값 안정”…주말에만 4건, SNS서 강조한 부동산 정책 의지

- “한동훈, 자기 가까이서 보려면 돈 더 내란 것··유료 토크콘서트, 해괴한 정치”

- 장동혁, 이 대통령 ‘망국적 부동산’ 언급에 “호텔 경제학 이은 호통 경제학?”

- 강훈식 “캐나다 ‘60조원 잠수함 사업’ 수주, 쉽지 않지만 자신 있다”