AI가 사람처럼 생각?···여러 개념 연결해 새로운 학습 가능

전체 맥락을 이해하기 위해서는 본문 보기를 권장합니다.

줄넘기를 처음 배운 아이가 있다고 해 보자.

이런 가운데, 미국과 스페인 연구진이 AI 언어 모델에 구성적 일반화를 학습시킬 수 있는 방법을 찾아 주목된다.

미국 뉴욕대와 스페인 폼페우파브라대학 연구진은 챗GPT 같은 AI 언어모델에 적용할 수 있는 '조합성을 위한 메타 학습(MLC, Meta-learning for Compositionality)'이라는 기법을 개발했다.

다만 이 방식은 AI가 학습한 데이터의 범위를 넘어서는 과제를 수행할 수 있게 해 주는 것은 아니라고 연구진은 밝혔다.

이 글자크기로 변경됩니다.

(예시) 가장 빠른 뉴스가 있고 다양한 정보, 쌍방향 소통이 숨쉬는 다음뉴스를 만나보세요. 다음뉴스는 국내외 주요이슈와 실시간 속보, 문화생활 및 다양한 분야의 뉴스를 입체적으로 전달하고 있습니다.

(지디넷코리아=한세희 과학전문기자)줄넘기를 처음 배운 아이가 있다고 해 보자. 이 아이는 곧 '줄을 두번 넘으라'거나 '앞으로 가며 줄넘기를 하라' 등의 개념도 이해할 수 있게 된다.

사람은 이처럼 새로 배운 개념을 이미 아는 다른 지식과 결합해 새로운 아이디어를 내거나 행동을 할 수 있다. 이를 '구성적 일반화(compositional generalization)' 또는 '체계적 일반화(systematic generalization)'라고 한다.

반면 인공지능(AI)은 이러한 능력이 없기 때문에 인간의 의식을 제대로 구현할 수 없다는 주장이 힘을 얻었다. AI의 이런 한계를 극복하기 위해 많은 연구가 이뤄졌지만 성과는 제한적이었다. GPT-4와 같은 첨단 대규모 언어 모델에서 여러 예상하지 못했던 능력의 창발이 나타났지만, 사람과 같은 일반화에는 어려움을 겪고 있다.

이런 가운데, 미국과 스페인 연구진이 AI 언어 모델에 구성적 일반화를 학습시킬 수 있는 방법을 찾아 주목된다. 이 연구는 학술지 '네이처'에 25일(현지시간) 실렸다.

미국 뉴욕대와 스페인 폼페우파브라대학 연구진은 챗GPT 같은 AI 언어모델에 적용할 수 있는 '조합성을 위한 메타 학습(MLC, Meta-learning for Compositionality)'이라는 기법을 개발했다. 구성적 일반화가 가능한 새로운 AI 모델을 만들지 않고도, 기존 AI 모델에 적용할 수 있다.

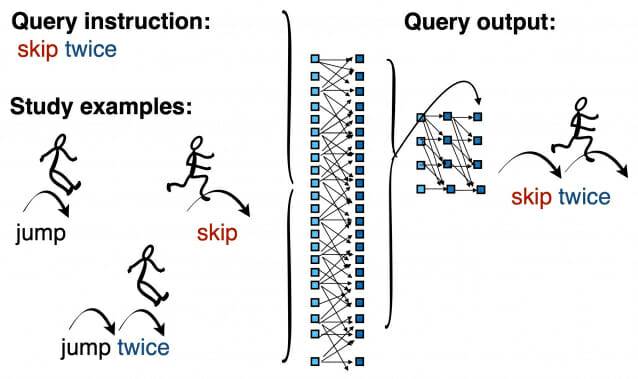

MLC는 분리된 개념을 조합해 새로운 것을 학습하기 위한 기법이다. 고정된 데이터셋이 아니라 계속해서 변하는 과제들을 통해 구성적 일반화를 학습한다. AI 모델은 '줄넘기하다(skip)'라는 단어를 새로 배운 후 '뛰다(jump)'나 '두번 뛰다(jump twice)' 처럼 그 동안 알고 있던 개념과 결합해 '두번 줄넘기하라(skip twice)'는 지시를 받는다. 이후 신경망을 거쳐 나온 결과를 처음 출제자가 의도한 결과와 비교한다.

이 학습 '에피소드'가 끝난 후, 이어서 '발끝으로 걷다(tiptoe)'라는 단어를 새로 배운 후 '발끝으로 뒷걸음쳐 교통 콘 주변을 돈다(tiptoe backward around a cone)'이라는 행동을 배우는 새로운 에피소드를 시작한다.

브렌든 레이크 뉴욕대 교수는 "지난 35년 간 인지과학과 인공지능, 언어학, 철학 분야 연구자들은 인공신경망이 사람과 같은 체계적 일반화를 할 수 있는지 논쟁해 왔다"라며 "이번 연구는 일반적인 신경망이 사람의 체계적 일반화 능력을 모방할 수 있음을 보인 첫 사례"라고 말했다.

연구진은 이런 방식의 MLC를 반복한 후 AI 모델의 구성적 일반화 능력을 테스트했다. 일반적 단어 외에도, 'zup'이나 'dax' 등 인위적으로 만든 무의미한 단어에 임의의 뜻을 부여한 후 AI가 이를 여러 방식으로 적용해 보게끔 했다.

MLC 학습을 한 AI는 실험에 참여한 인간과 비슷하거나 더 나은 결과를 보였다. 또 실험에 참가한 사람과 MLC 학습 AI 모두 챗GPT나 GPT-4보다는 나은 결과를 보였다.

다만 이 방식은 AI가 학습한 데이터의 범위를 넘어서는 과제를 수행할 수 있게 해 주는 것은 아니라고 연구진은 밝혔다.

마르코 바로니 폼페우파브라대학 교수는 "챗GPT 같은 초거대 언어모델은, 최근 많이 개선되긴 했지만, 여전히 구성적 일반화에 어려움을 겪고 있다"라며 "MLC가 초거대 언어모델의 관련 능력을 향상시킬 수 있을 것"이라고 말했다.

논문 제목은 Human-like systematic generalization through a meta-learning neural network 이다.

한세희 과학전문기자(hahn@zdnet.co.kr)

Copyright © 지디넷코리아. 무단전재 및 재배포 금지.

- 챗GPT, BBC 콘텐츠로 데이터 학습 못 한다

- 생성AI의 저작권 침해, 어디까지 허용해야 할까

- "생성 AI가 암 연구에 획기적 발전 일으킨다"

- '몰트북' 나비효과?…韓 상륙한 AI들의 수다

- 롯데면세점, 3년만에 인천공항 복귀...득일까 실일까

- 스페이스X, xAI 인수했다…우주 데이터 센터 건설 계획 발표

- [르포] 코어·모터·가공까지…뉴로메카 포항 생산거점 승부수

- 통신 3사 4분기 합산 영업익 5000억원 밑돈다

- '움직이는 AI' 이어 '알아서 하는 AI'로…정부, 새 연합군 띄운다

- "韓 고정밀 지도, 구글·애플에 내주면 10년간 최대 197조원 피해"