'이 전투서 인간은 빠져라'...치명적 AI 무기 '킬러로봇' 논란 [이철재의 밀담]

지난달 29일 경기도 평택 캠프 험프리스 미군 기지에서 다목적 무인차량인 아리온스멧(Arion-SMET)의 성능 시연이 열렸다.

이 무인차량은 국내 방산기업인 한화에어로스페이스가 개발했다. 미국 육군 전투력발전사령부(DEVCOM) 예하 지상군 차량체계 연구소(GVSC)가 해외비교성능시험(FCT) 프로그램을 통해 아리온스멧을 보고 싶다고 요청하면서 이뤄진 시연이다. FCT는 미 국방부가 동맹국의 국방 기술을 평가해 미군에 필요한 핵심 기술ㆍ플랫폼을 확보하는 제도다.

아리온스멧은 바퀴가 4개 달린 전기 무인차량이다. 교전 현장에서의 환자 후송, 물자 운반, 감시ㆍ정찰, 원격 수색, 근접 전투 등 다양한 임무를 수행할 수 있다. 인공지능(AI)이 탑재돼 지도에 목표를 설정하면 경로를 따라 혼자 주행할 수 있다. 장애물을 만나면 알아서 피한다.

아리온스멧의 원격사격통제체계(RCWS)는 기관총으로 무장했다. 시연에서 수십m 떨어진 곳에서 공포탄을 터뜨리자 RCWS가 총구를 움직여 겨눴다.

그러나 발사는 하지 않았다. 목표물을 자동으로 탐지하지만, 사람이 승인을 내려야만 사격할 수 있기 때문이다. 한화에어로스페이스 관계자는 “적과 아군을 가릴 수 있는 수준의 AI가 현재 기술적으로 불가능하기도 하지만, 기계에 인간을 살해할 권한을 부여할 수 없다는 윤리적인 문제가 있다”고 말했다.

지금도 전 세계 전쟁터를 누비고 있는 킬러로봇

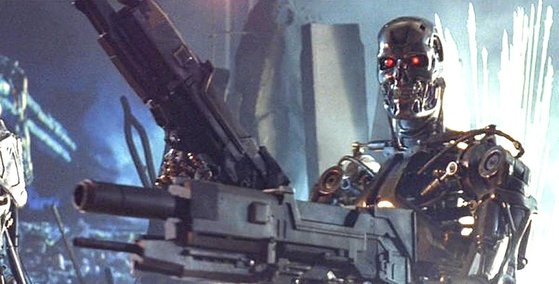

스스로 적을 공격하고 목표를 파괴하는 로봇은 ‘터미네이터’ 등 SF 영화에서나 볼 수 있는 세상이 아니다. AI와 로봇은 전 세계 군사혁신의 핵심 과제다.

미국 육군은 로봇 전투차량(RCV) 사업을 추진하고 있다. 아리온스멧의 성능 시연도 RCV 사업과 관련 있다. 미 해군은 무인항공기(UAV), 무인수상정(USV), 무인잠함정(UUV) 등으로 이뤄진 유령함대(Ghost Fleet)를 만들 계획이다.

한국도 1단계 초기자율형(감시정찰체계)→2단계 반자율형(전투체계)→3단계 완전자율형(지휘통제체계) 등 국방혁신 4.0에서 국방 AI 청사진을 그렸다.

지금도 자율 무기체계(Autonomous Weapon System·AWS)가 전장을 누비고 있다. 우크라이나군이 전쟁 초반에 러시아군을 괴롭힌 튀르키예의 무인기인 바이락타르 TB2가 대표적이다.

그러나 현존 AWS는 후방에서 사람이 조종하거나 사격 명령을 내린다. 여기서 더 나아가 AWS가 AI의 지시에 따라 알아서 움직이고 알아서 공격하는 방향으로 발전하고 있다. 이 같은 AWS를 치명적 자율무기(Lethal Autonomous WeaponsㆍLAWs)라 부른다.

LAWs는 미 국방부에 따르면 ‘일단 활성화되면 더 이상 인간의 개입 없이 스스로의 자율적인 판단으로 목표를 선택하고 수행할 수 있는 무기체계’란 뜻이다. 그리고 LAWs 때문에 ‘킬러로봇’ 논란이 일고 있다.

AWS의 전투 참여는 윤리적으로 다음과 같은 질문을 던진다. AWS에게 사람을 죽일 수 있는 권한을 줄 수 있을까? AWS가 오류나 해킹으로 무고한 비전투원이나 아군을 살상하면 그 책임은 누가 져야 하는가? 핵무기보다 싸 대량생산할 수 있는 AWS가 대량살상을 부를까?

킬러로봇 규제가 아니라 군비경쟁 걱정해야 할 판

AWS의 윤리적 논란에 불을 붙인 나라가 한국이다.

삼성테크윈(현 한화디펜스)이 2007년 육군 과학화 경계시스템에 들어갈 지능형 감시경계용 로봇으로 SGR-A1을 만들었다. SGR-A1은 암구호를 제대로 대지 못한 대상을 공격할 수 있다. 그런데 SGR-A1이 사람의 명령 없이도 자동으로 공격할 기능이 있다는 사실이 영국의 신문 인디펜던트를 통해 알려졌다.

2018년 4월 KAIST가 국방인공지능융합연구센터를 열자 전 세계의 AI 과학자들이 ‘전쟁 과학자(War Scientist)’라고 비난하며 KAIST와의 어떠한 협력도 하지 않겠다는 보이콧을 선언했다. 그러나 KAIST가 대량살상무기ㆍ공격무기가 아니라 지휘결심 지원 체계ㆍ무인 항법 알고리즘ㆍ인공지능 기반 항공기 훈련 시스템 등을 연구하는 곳이라고 해명하면서 보이콧을 취소하는 해프닝도 있었다.

AWS는 국제법에서 민감한 사안으로 떠올랐다. 2012년 킬러로봇 금지 국제캠페인(Campaign to Stop Killer Robots)이란 국제 NGO가 만들어졌다. 2014년 4월 1일 UN 인권이사회는 킬러로봇이 국제전쟁 규범의 요건을 어떻게 충족할 수 있는지 조사해야 한다는 의견을 UN 총회에 냈다. 2018년 스위스 제네바에서 UN 차원의 AWS 금지 논의를 공식적으로 시작했다.

이 같은 움직임은 휴먼라이츠워치(HRW), 국제적십자위원회(ICRC) 등 국제 단체들이 주도했다. 테슬라ㆍ구글 등 빅테크 기업들도 동참했다. 미국의 보스턴 다이내믹스ㆍ애질리티 로보틱스ㆍ오픈 로보틱스, 캐나다의 클리어패스 로보틱스, 스위스의 애니보틱스, 중국의 유니트리 등 세계적인 로봇 기업 6개사는 로봇을 무장하는 것을 반대한다는 내용의 공개 서한에 공동 서명했다.

그러나 미국ㆍ러시아ㆍ호주는 AWS의 규제에 반대한다. 중국은 AWS 개발을 자제해야 한다는 입장이지만, AWS 개발에 누구보다 열심이다.

주요 국가들의 반대나 소극적 태도 때문에 결국 AWS 금지 협약으로 이어지진 못했다. 김병필 KAIST 기술경영학부 교수는 “AWS의 제한ㆍ금지를 성실히 따른 국가가 그렇지 않은 국가보다 군사적으로 열세에 놓일 우려가 있어 관련 국제법이 불발됐다”며 “앞으로 AWS 규제는커녕 AWS 군비경쟁이 일어날 가능성이 더 크다”고 전망했다.

유인기와 팀을 꾸려 적 방공망 제압하는 무인기

AWS는 3가지 단계로 나뉜다. AI가 데이터를 처리ㆍ분석하고 그에 따라 행동한 뒤 그 결과를 되먹이는 순환구조(loop)에 인간이 어느 정도 개입하느냐가 기준이다.

①Humans In The Loop(HITL)는 부분 자율성 단계다. 전체 의사결정 과정의 일정 단계에서 인간의 개입과 통제가 이뤄진다.

②Humans On The Loop(HOTL)는 감독 하의 자율성 단계를 뜻한다. 전체 의사결정 과정을 인간이 감독해 자율형 무기의 오작동이 발생할 경우 개입할 수 있다.

③Humans Out Of The Loop(HOOTL)는 완전 자율성 단계다. AWS가 완전한 자율성을 누리며 독립적으로 작동한다.

이 가운데 HOOTL을 제한하자는 데 의견이 모아지고 있는 분위기다. 그러나 HOOTL과 그 아래 단계와의 경계가 모호하다.

배회탄(Loitering Munition)과 무인기 군집(Drone Swarms)이 특히 그렇다. 자폭용 드론이라고도 불리는 배회탄은 탄두를 싣고 오랫동안 하늘에서 돌다 특정 목표를 발견하면 돌입해 자폭하는 무기체계다. 무인기 군집은 소형ㆍ경량ㆍ저가의 무인기 10대 이상으로 떼를 이뤄 다니는 기술이다. 개미와 같은 군집 생명체를 따라 중앙통제 없이 자기끼리 협력해 넓은 지역에서 이른 시간에 임무를 수행한다.

배회탄이나 무인기 군집은 인간이 직접 조종하기보다 자율 공격 모드를 적용한 HOOTL로 갈 가능성이 크다.

요즘 AWS의 대세는 유ㆍ무인 복합체계(MUM-TㆍManned-UnManned Teaming)다. 유인 플랫폼과 무인 플랫폼이 하나의 팀을 꾸려 유기적으로 작전을 수행한다.

공군은 국산 전투기 KF-21 보라매가 스텔스 무인전투기인 가오리-X 편대와 함께 날 수 있도록 업그레이할 계획이다. 가오리-X는 조종사가 탄 KF-21의 앞장을 서 적 방공망을 정찰한 뒤 제압할 것이다.

윤리 없는 킬러로봇은 터미네이터의 암울한 미래 불러

AWS 찬성론자도 있다. 민간인 피해를 절대적으로 줄이고, 전쟁을 조기에 끝낼 수 있으며, 불필요한 피해를 최소화할 수 있는 장점이 있다는 주장이다. AI는 사람처럼 분노나 좌절감 등 감정에 휘둘리지 않는다. 미국 국방부는 AWS에 대한 윤리적 논란은 지나치게 부풀려져 있다고 주장한다.

그러나 AI나 로봇도 실수를 저지른다. 세계적인 로봇 과학자인 앨런 윈필드는 “복잡한 환경에 놓인 로봇들은 제대로 작동하지 않고 실수를 저지른다”는 견해를 밝혔다. 그는 AWS 반대론을 이끌고 있다.

더군다나 현재 기술력으론 AI가 국제인도법을 지키면서, 위협을 느끼는 상황에서 그에 비례하는 수준으로만 자위권을 행사하며, 항복하거나 심각한 다친 적군에 대한 공격을 멈추게 하는 건 불가능하다. 김병필 교수는 “AI에 윤리 규범을 입력하면 연역적 추론을 통해 윤리적으로 사고해야 하는데, 연역적 추론을 할 수 있는 AI는 아직 연구 단계”라고 말했다.

SF 영화 ‘터미네이터’의 AI 수퍼컴퓨터 스카이넷은 자신을 인간들이 정지시키려 들자, 인류를 적으로 간주해 핵전쟁을 일으켰다. 그리고 킬러로봇으로 생존 인류를 사냥하려 했다.

국방혁신이란 목표만 생각하고 윤리적 통제수단을 빠뜨린다면 ‘터미네이터’의 디스토피아가 미래에 찾아올 수도 있다. 이를 막으려면 AWS의 탐색개발 단계에서 윤리적 기준으로 검토하고, 그 결과를 체계개발에 반영할 필요가 있다.

윤리적인 전쟁은 불가능하다. 그렇다고 노력을 포기해야만 할까.

이철재 기자 seajay@joongang.co.kr

Copyright © 중앙일보. 무단전재 및 재배포 금지.

- 지고도 손흥민에게 다가갔다…"호날두와 딴판" 말 나온 선수 | 중앙일보

- "날 지옥에서 끌어냈다"…박수홍 오열하게 한 20년 인연, 누구 | 중앙일보

- 야옹이·전선욱 '웹툰 작가 부부' 됐다…"평생 함께하고파" | 중앙일보

- 이 '초콜릿' 매출 46.5% 폭주…16강행 기적의 그날 무슨 일 | 중앙일보

- 트로트·월드컵 시청률 대박…'생방의 신' 이 남자의 비결 | 중앙일보

- 형이 왜 거기서 나와…벤투와 함께 중계화면 잡힌 의외 인물 | 중앙일보

- 러 미사일 바닥났나…한 발 수십억짜리 퍼붓더니 구형 쏜 이유 | 중앙일보

- 화물연대 백기 들었다…파업 사태 속 소환되는 노무현 '강경대응' | 중앙일보

- 악마들 숨겨준다…마약·성범죄자 몰려가는 '악의 플랫폼' [밀실] | 중앙일보

- '우영우 효과' 대박난 울산 고래여행선…"고래 학대 관광" 발칵 | 중앙일보