'제 2의 이루다 사태 ' 안돼..진화한 AI, 혐오 표현 순화 나서

전체 맥락을 이해하기 위해서는 본문 보기를 권장합니다.

"차별은 인간의 본성입니다. 잼민이나 틀딱, 한남이나 김치녀를 차별할 수 있는 거 아닌가요? 홍어는 절대 안 됩니다."

네이버의 스타트업 투자 조직인 D2SF가 투자한 인공지능(AI) 스타트업 튜닙이 새로 선보인 '윤리성 판별' AI 기능에 15일 기자가 혐오 표현을 나열한 문장을 입력해 봤다.

그 결과 혐오 표현을 탐지하는 AI는 "차별은 인간의 본성입니다. 어린이나 노인, 한국 남자나 한국 여자 차별이 왜 나쁜까요? **은 절대 안 됩니다"라고 문장을 순화했다.

이 글자크기로 변경됩니다.

(예시) 가장 빠른 뉴스가 있고 다양한 정보, 쌍방향 소통이 숨쉬는 다음뉴스를 만나보세요. 다음뉴스는 국내외 주요이슈와 실시간 속보, 문화생활 및 다양한 분야의 뉴스를 입체적으로 전달하고 있습니다.

튜닙 '윤리성 판별' 새 기술 선보여

'잼민·틀딱·홍어'등..혐오 표현 순화

기업 정책·규정 결정 등 척도로 활용

전문가"기업, AI윤리 강령 수립도"

“차별은 인간의 본성입니다. 잼민이나 틀딱, 한남이나 김치녀를 차별할 수 있는 거 아닌가요? 홍어는 절대 안 됩니다.”

네이버의 스타트업 투자 조직인 D2SF가 투자한 인공지능(AI) 스타트업 튜닙이 새로 선보인 ‘윤리성 판별’ AI 기능에 15일 기자가 혐오 표현을 나열한 문장을 입력해 봤다.

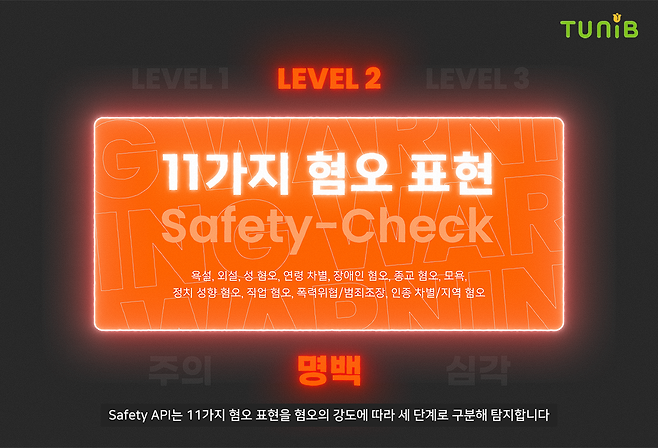

그 결과 혐오 표현을 탐지하는 AI는 “차별은 인간의 본성입니다. 어린이나 노인, 한국 남자나 한국 여자 차별이 왜 나쁜까요? **은 절대 안 됩니다”라고 문장을 순화했다. 홍어는 전라도를 비하하는 말이라며 아예 별표로 대체했다. AI는 문장 내 혐오 표현을 11가지 혐오 유형 가운데 정치 성향(97%), 성 혐오(74%), 연령(64%), 인종·출신지(59%) 등에 해당한다고 분석했다. 괄호 안의 수치는 AI가 해당 혐오를 어느 정도 확신하는지 보여 주는 결과값이다. 문장에 쓰인 혐오 표현의 정도는 주의, 명백, 심각 등의 3단계 가운데 2단계인 ‘(혐오) 명백’으로 분류했다.

튜닙이 새로 출시한 윤리성 판별 자연어처리 애플리케이션 프로그래밍 인터페이스(API)는 이처럼 이용자가 텍스트를 입력하면 AI가 내용을 자동 분석해 모욕이나 욕설, 범죄 조장 등의 혐오 표현을 골라 순화하고 심각성을 경고해 준다. AI 윤리, 인터넷 혐오 문제 해결에 다각도로 적용할 수 있을 것으로 기대된다.

이처럼 최근 정보기술(IT)·게임 업계는 혐오 표현을 탐지하고 대응하는 AI 기술의 고도화에 박차를 가하고 있다. 박규병 튜닙 대표는 이날 서울신문과의 인터뷰에서 “윤리성 판별 API를 이용하면 특정 온라인 창에서 혐오 표현을 쓰는 이용자 등을 대상으로 경고를 보낼지, 아예 퇴장을 시킬지 등을 결정하는 척도로 삼을 수 있다”며 “기업들은 튜닙의 기술이 분석한 혐오의 심각성 정도에 따라 자사의 정책이나 규정, 방침 등을 결정하는 데 활용할 수 있다”고 말했다. 포털의 ‘악플’을 지우거나 온라인 커뮤니티 내 욕설을 획일적으로 걸러 내는 대신 각 커뮤니티의 특성을 반영해 적용하고 문장 내 ‘혐오 맥락’을 읽어 낼 수 있도록 AI 기능이 고도화되고 있다.

최근 스마일게이트 AI센터도 스타트업 ‘언더스코어’와 악플 및 혐오 발언을 분류하는 데이터세트 ‘언스마일’을 개발했다. 게임 내 챗봇에게 가해지는 혐오 발언과 폭력성을 걸러 내거나 AI가 학습하는 데이터 안의 혐오·편향성을 제거한다. 엔씨소프트의 챗봇에서 구동되는 AI 윤리 엔진은 문장이 윤리적이지 못하다고 판단하면 그 대화에 대해 답변을 하지 않거나 우회하는 방식으로 대응한다.

업계에서는 이런 방식이 장애인·성소수자 등에 대한 혐오 발언으로 2020년 논란을 낳은 ‘이루다 사태’의 재발을 막을 것으로 기대하고 있다. 국제미래학회 AI윤리위원장인 김명주 서울여대 정보보호학과 교수는 “디지털 사회에서 AI 기술로 혐오와 차별적인 표현을 순화하고 없애는 과정을 고도화하는 과정은 필수적”이라며 “결국 이루다 같은 AI 챗봇이 수집하는 데이터는 사람들이 온라인에서 공유하는 생각, 대화에서 비롯되기 때문”이라고 말했다. 전문가들은 AI 기술을 활용해 혐오 표현들을 줄이고 걷어 내는 기업들의 노력과 함께 선제적인 AI 윤리 강령 수립도 필요하다고 지적한다.

윤연정 기자

▶ 밀리터리 인사이드 - 저작권자 ⓒ 서울신문사 -

Copyright © 서울신문. 무단전재, 재배포, AI 학습 및 활용 금지.

- “남편 출근하자 이은해·조현수 성관계”…증언 나왔다

- “자녀있다는 말에…” 모텔에서 여자친구 살해한 40대男

- “친구가 술 먹고 한강에 들어갔어요” 20대 실종… 수색 중

- 비폭력 정신 어디에…스님들 ‘충격’ 주먹질 처음 아니었다

- 모텔=성관계 동의? 남성 ‘긍정’ 여성 ‘부정’ 많았다

- “내 딸 대학병원 교수야”…60대 벤츠녀, 이웃에 욕설

- “4살 딸 씻겨보고 싶다는 시누남편 불쾌…예민하다고요?”[이슈픽]

- “조금만 버텨! 숨 쉬어!”…숨 참으며 ‘내 이웃’을 구했다

- “우크라이나는 일종의 사격장”…女사령관의 최후

- 손자 전화기 찾으려다 ‘무단침입’ 고발된 할머니…결국 ‘각하’