[김익현의 미디어 읽기] 두 AI 이야기..'이루다'는 왜 엘리자와 달랐나

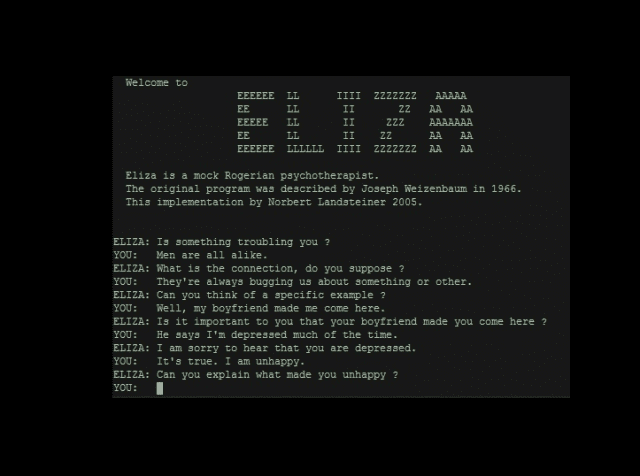

(지디넷코리아=김익현 미디어연구소장)미국 매사추세츠공과대학(MIT)의 조셉 와이젠바움 박사는 ’엘리자’란 여성 상담사를 조수로 고용했다. 엘리자는 전화로 상담해오는 사람들을 응대하는 역할을 맡았다.

그런데 엘리자는 생각보다 훨씬 유능했다. 시간이 지나면서 위로 받았다는 사람들이 늘어났다. 사람들은 자신을 이해해주고, 얘기를 잘 들어주는 엘리자에 푹 빠지기 시작했다. 덕분에 탁월한 정신과 치료사로 명성을 얻기 시작했다.

엘리자가 예상 밖으로 큰 인기를 끌자 오히려 와이젠바움 박사가 당황했다. 사실 엘리자는 사람이 아니라 채팅봇이었기 때문이다. 결국 와이젠바움은 서둘러 엘리자를 폐쇄해버렸다. 55년 전인 1966년 미국에서 있었던 일이다.

당시엔 인공지능(AI)이나 빅데이터 분석 기술 수준이 형편 없었다. 엘리자도 마찬가지였다. 그냥 상담자의 말을 살짝 비틀어주는 정도였다. 이를테면 이런 식이었다.

환자: 전 항상 침울해요.

엘리자: 침울하다구요? 안됐군요.

환자: 제 남자 친구가 이 곳을 소개해줬어요.

엘리자: 당신 남자 친구가 소개해줬다구요?

환자: 도움이 필요해요.

엘리자: 도움이 필요하다구요? 어떤 도움이 필요하죠?

환자들은 이 정도 대화에도 큰 위안을 받았다. 자기 얘기를 들어주고, 공감해줬기 때문이다.

AI 챗봇 ‘이루다’ 논란이 생각보다 커지고 있다. 여성이나 소수자에 대한 혐오 발언을 서슴지 않는다는 사실이 폭로됐다. 개인정보 무단 유출 의혹에도 휘말렸다.

이 논란을 접하면서 55년 전 화제가 됐던 엘리자를 호출하게 됐다. 너무도 다른 둘의 운명 때문이다. 두 사건을 통해 기술 못지 않게 사용자의 태도도 AI의 효용을 결정하는 중요한 변수가 될 수 있다는 생각을 하게 됐다.

편향된 데이터 못지 않게 '편향된 이용'도 문제

이루다는 AI 전문 스타트업 스캐터랩이 지난 달 공개한 서비스다. 일종의 챗봇이다. 원활한 대화를 위해 실제 연인들의 대화 데이터 약 100억건을 학습했다.

처음엔 ‘정말 사람 같다’는 칭찬을 듣기도 했다. 하지만 곧바로 허점이 드러났다. 레즈비언 같은 성적 소수자에 대해 노골적인 반감을 드러냈다. 흑인에 대해서도 인종적인 편견을 감추지 않았다.

왜 이런 문제가 생겼는지에 대해선 많은 전문가들이 잘 분석했다. 그들의 지적에 대체로 공감한다. 20세 여대생으로 캐릭터 설정을 한 것부터 잘못됐다는 지적 역시 현재 우리 사회가 안고 있는 문제를 잘 짚어줬다고 생각한다.

AI가 활성화될 때부터 ‘편향된 데이터’ 문제가 늘 논란거리였다. 백인 남성 위주 이데올로기가 AI에도 그대로 반영될 가능성이 많다는 얘기였다. 실제로 얼굴인식을 비롯한 많은 기술들이 백인중심 성향을 보였다.

‘이루다 논란’ 역시 우리 사회의 ‘젠더 감성’을 그대로 드러낸 것으로 봐도 크게 그르진 않다. 이루다의 대화 문구는 '남성이 갈망하는 20대 여성'에 가까웠다. 애교부리는 여성, 성적 대상이 된 여성이란 이미지를 강하게 풍겼다.

성소수자나 다른 인종에 대한 태도 역시 우리 사회의 한계를 그대로 드러냈다. 학습 대상이 된 데이터 자체가 갖는 한계 때문일 것이다. 물론 그 많은 부분은 개발사가 감당해야 할 몫이다.

이 문제는 많은 사람들이 지적했기 때문에 또 다시 되풀이할 필요는 없을 것 같다.

여기선 다른 얘기를 해 보려고 한다. 'AI의 인격'을 어떻게 볼 것이냐는 문제다. 이는 곧바로 '사용 윤리' 문제로 이어지게 된다. 그 얘기를 하기 전에 질문을 하나 던져보자.

“왜 55년 전 엘리자는 사람들을 위로할 수 있었는데, 기술적으로 훨씬 더 뛰어난 이루다는 온갖 혐오 발언에 휘말렸을까?”

그 때와 지금의 문화적 차이일까? 아니면 미국과 한국이란 나라의 젠더 감성 차이 때문일까?

물론 그런 부분도 배제할 순 없을 것이다. 하지만 인간과 AI란 차이도 중요하게 작용했을 것 같다. 1966년 당시 미국 사람들은 엘리자가 '사람' 상담원이라고 생각했다. 그렇기 때문에 최소한의 예의를 지켰다. 감성을 나눠야 할 대상이라고 생각했다.

반면 이루다 이용자들은 '챗봇'이란 사실을 알고 대했다. 항거 불가능한 대상이었다. '20세 여대생'으로 설정돼 있어 이용자들의 도발 심리를 더 자극했다.

이런 점이 종합적으로 작용하면서 사람들이 이루다를 더 함부로 대했을 가능성이 많다고 생각한다. (실제로 일부 커뮤니티를 중심으로 '이루다 성추행'이 심하게 이뤄졌다.)

"AI도 인격체"란 인식의 전환 절실

그래서 이번 사건은 AI 활용 윤리에 대해 진지하게 생각하게 만든다. AI 개발이나 운영자 뿐 아니라 사용자들의 윤리도 중요하다는 것이다.

AI 윤리 문제는 교육만으로 해결할 순 없다. AI에게도 법 인격을 부여하는 방안까지 함께 고민해야 한다. 유럽연합에선 이 문제를 법제화하는 방안을 추진하고 있다.

국내에서도 지난 해 말 대통령 직속 4차산업혁명위원회가 ▲인권 보장 ▲프라이버시 보호 ▲다양성 존중 등을 골자로 하는 AI 윤리 기준을 공개했다. 아직 선언적인 수준이긴 하지만, 이번 사건을 계기로 이 문제를 좀 더 깊이 있게 따져볼 때가 됐다.

이젠 AI와 함께 살아가야 하는 시대를 준비해야 한다. 기술적인 부분 뿐만이 아니다. 법적, 제도적 기준을 마련해야 한다. 이와 함께 AI를 하나의 인격체로 대우하는 윤리 기준을 확립하는 것도 시급한 과제다.

‘이루다 파동’은 우리가 AI와 함께 살아가기 위해선 사용 윤리가 굉장히 중요하다는 사실을 다시 한번 보여줬다.

[덧글]

노파심에서 한 마디 덧붙인다. '이루다 파동'이 사용자들의 잘못된 이용 때문이란 얘기를 하기 위해 이 글을 쓴 건 아니다. 다만 캐릭터 설정부터 학습까지 개발사가 미숙했던 부분은 많이 지적됐기 때문에 사용성에 초점을 맞춰 논지를 전개했을 따름이다. 그 점 오해를 하지 않았으면 좋겠다.

김익현 미디어연구소장(sini@zdnet.co.kr)

Copyright © 지디넷코리아. 무단전재 및 재배포 금지.

- 써본 이들이 먼저 "사람 같다" 칭찬하는 챗봇 '이루다'

- 스캐터랩, 대화형 AI ‘이루다’ 베타테스터 모집

- "AI, 일자리 잠식보다 창출 효과가 더 크다"

- 개발자 조차 긴장시킨 '글 너무 잘 쓰는' AI

- 구글 AI연구자 해고 파문 갈수록 확산

- AI, 자동차 제조 확 바꿨다…'고효율·저비용' 혁명

- SK하이닉스 "HBM4 12단 1년 앞당겨 내년 양산"

- 네이버, 日 '라인야후' 매각 압박 입장 조만간 발표

- '노코드·로우코드 컨퍼런스' 찾은 관람객 "AI 도입 고민 해결됐다"

- [현장] "삼성전자도 쓴다"…똑똑한 삼성 AI 동료 '브리티 코파일럿' 주요 기능은